2Dアニメーションソフトウェア

コマ撮りとアニメーション

Lightning Doodle

Deepmotion Animate 3D

Matterport Proカメラ

Matterport

Sketchfab

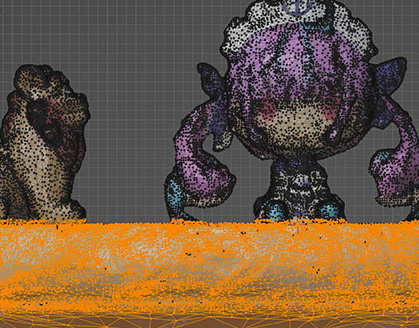

Deleting faces in Blender

Metashape

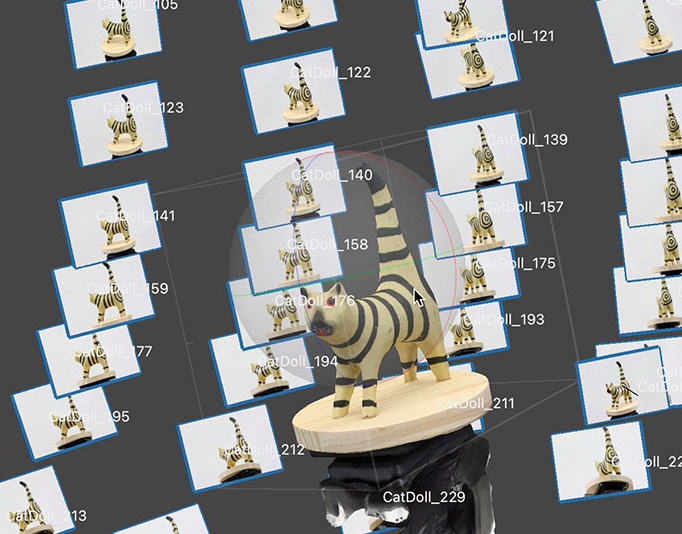

Turntable Based 3D Scan System

3D Body Scan

RealityCapture

3D Scanning Overview

Adobe Media Encoder

Image Morphing

Morphing Part 3

Morphing Part 2

Morphing Part 1

Kinetic Typography Part 3

Kinetic Typography Part 2

Kinetic Typography Part 1

Time Remapping

Puppet Tool

Jumping Grasshopper

Adobe After Effects Part 3

Adobe After Effects Part 2

Adobe After Effects Part 1

Music & Sound Effects Library

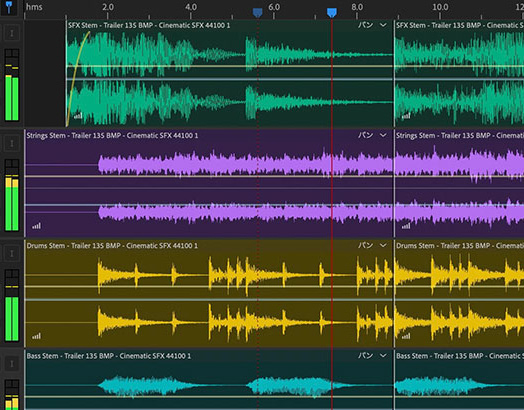

音声波形編集

Adobe Premiere Pro Part 4

Adobe Premiere Pro Part 3

Adobe Premiere Pro Part 2

Adobe Premiere Pro Part 1

Smartphone撮影

カメラ・ビデオ技術用語

三脚の使い方

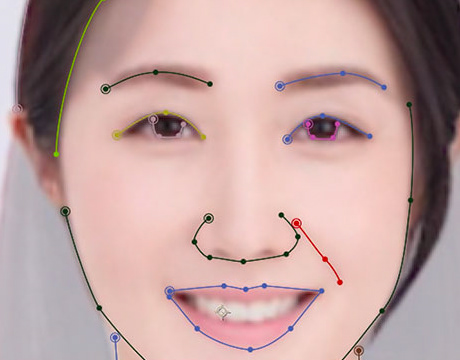

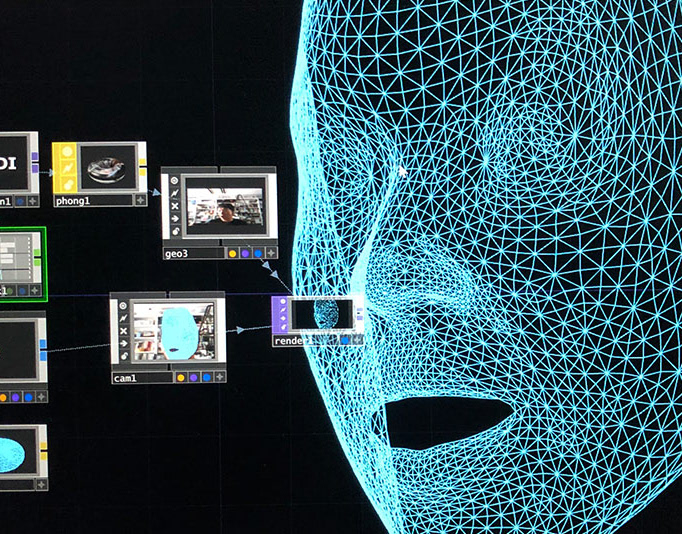

Face Tracking + TouchDesigner

TouchDesigner + Azure Kinect DK

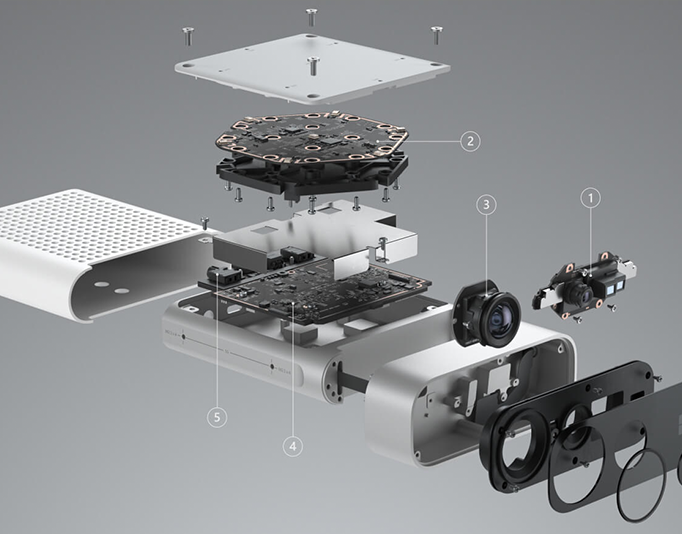

Azure Kinect DK

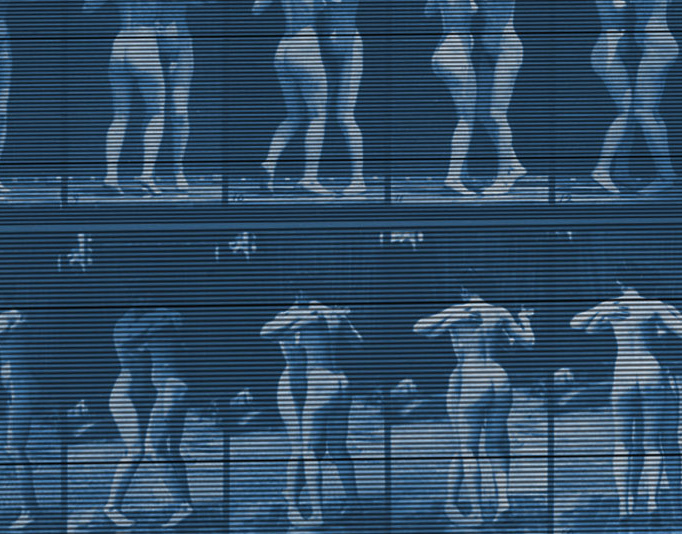

Slit Scan

Time Displacement

Feedback

Audio Reactive ver.2 - Part3

Audio Reactive ver.2 - Part2

Audio Reactive ver.2 - Part1

TouchDesigner+2D

TouchDesigner基礎

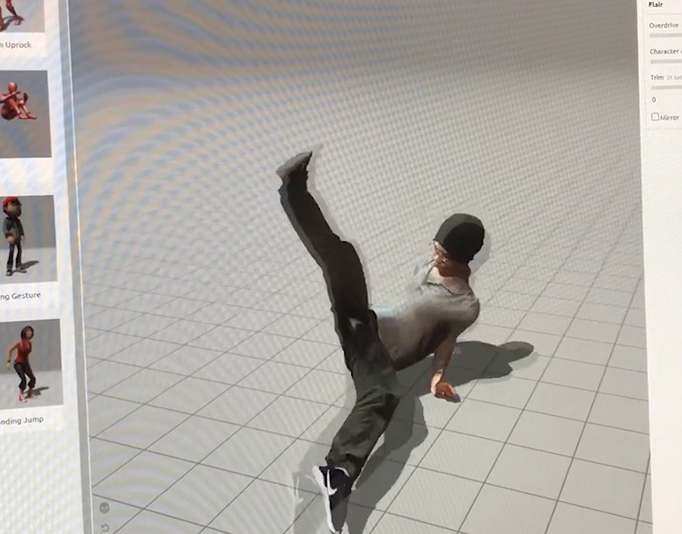

Mixamo

DTP